Unsere Gesellschaft steht vor zwei entscheidenden Fragen: Was bedeutet es, wenn künstliche Intelligenz (KI) zunehmend unsere Freiheitsrechte bestimmt? Und was sind die Folgen für die Menschen, gegen die KI inhärent anders bewertet und behandelt?

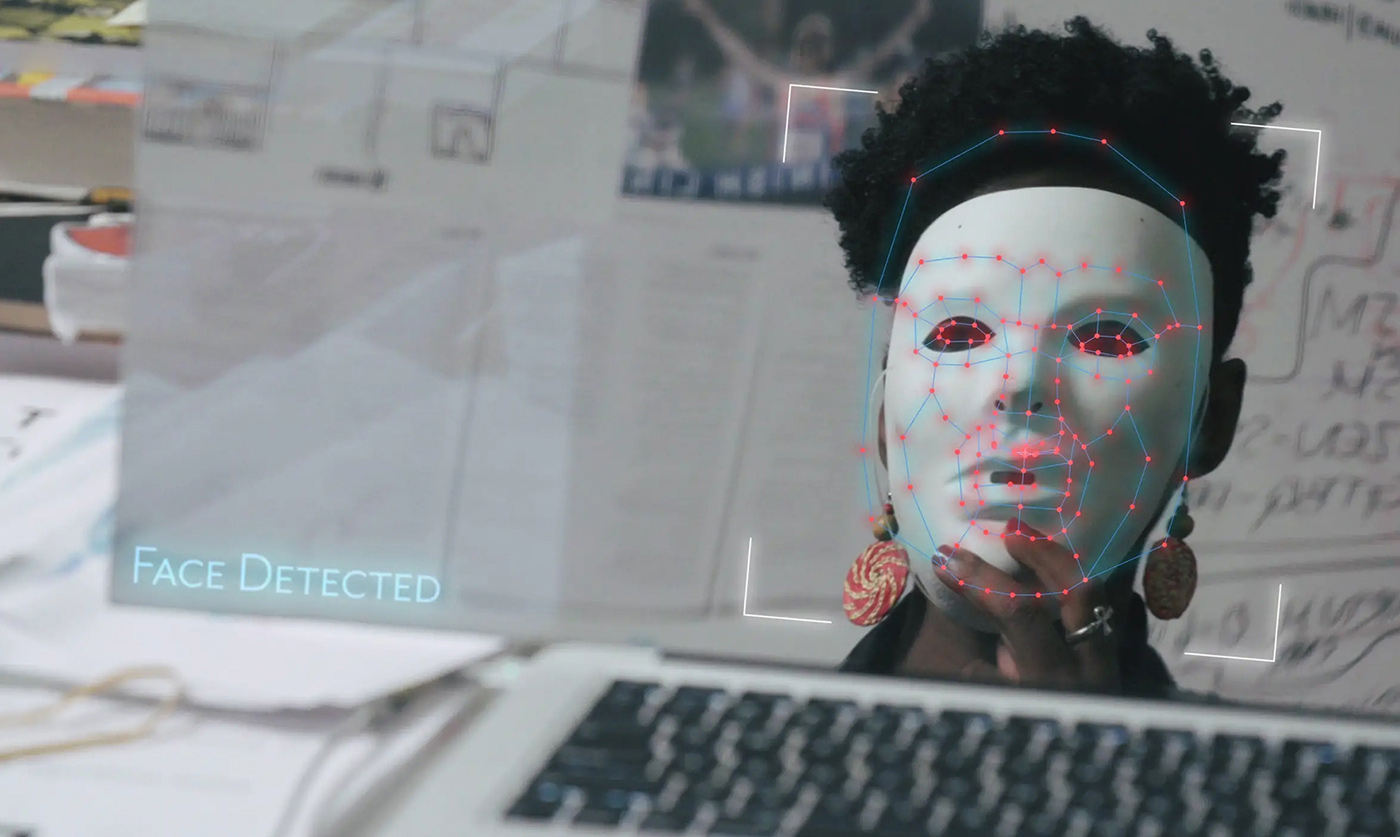

Als Joy Buolamwini, Forscherin am MIT Media Lab, entdeckt, dass die meisten Gesichtserkennungsprogramme Gesichter mit dunklerer Hautfarbe und Frauengesichter nicht richtig erkennen, beginnt sie eine Untersuchung der weit verbreiteten Vorurteile (Bias) in Algorithmen. Es stellt sich heraus, dass künstliche Intelligenz nicht neutral ist. Buolamwini und weitere Expertinnen und Aktivistinnen setzen sich bei der US-Politik auf höchster Ebene dafür ein, dass unsere Bürgerrechte geschützt werden.

Modern society sits at the intersection of two crucial questions: What does it mean when artificial intelligence increasingly governs our liberties? And what are the consequences for the people AI is biased against? When MIT Media Lab researcher Joy Buolamwini discovers that many facial recognition technologies do not accurately detect darker-skinned faces or classify the faces of women, she delves into an investigation of widespread bias in algorithms. As it turns out, artificial intelligence is not neutral, and women are leading the charge to ensure our civil rights are protected.